서 론

재료 및 방법

1. 하드웨어 및 소프트웨어

2. 데이터 세트

3. 영상 전처리

4. K겹 교차검증

5. 모델 아키텍처 선택

6. 성능지표

7. Keras.callbacks

8. 학습 모델

결과 및 고찰

1. 콜백 함수

2. 아키텍처 비교

3. 손실함수 및 활성화함수 비교

4. 옵티마이저 비교

결 론

서 론

국내 농업은 2000년대 초반까지 지속적인 성장을 하였다. 하지만 최근 농가 소득의 정체, 곡물 자급률 하락, 농촌인구의 감소와 농촌 고령화, 지구온난화 및 이상기후 현상 등으로 인해 어려움을 겪고 있다. 또한 세계적으로 기후 변화와 물 부족, 급속한 도시화로 인한 경작지 감소, 인구 고령화로 인한 식량 수급 문제가 예상된다(KREI, 2016). 정보통신기술(ICT)을 활용해 원격·자동으로 작물의 생육환경을 관측하고 자동 시스템으로 최적의 상태를 관리하는 과학 기반의 농업방식인 스마트팜 기술이 이러한 농촌 문제의 해결안으로 주목을 받고 있다(NABO, 2022). 또한 최근 농업에서 차지하는 비중이 큰 상추와 같은 시설채소를 중심으로 스마트팜 보급 면적이 증가하는 추세이다(KREI, 2006). 이러한 시설채소 및 원예작물은 물가 경제에 미치는 영향이 높아, 생산성을 향상하고 생육 비용을 줄일 수 있도록 데이터 기반의 생육 모델 개발 요구가 증가하고 있다(Kim 등, 2017). 그러나 스마트팜 기술 개발 현황에 따르면 통합제어 기술, 재배시설 기술, 광원 관련 기술이 대부분(74%)을 차지하고, 작물 생장 모니터링 기술은 전체에서 9%로 다른 기술에 비해 개발이 저조한 것을 확인할 수 있다(COMPA, 2019).

스마트팜 기술의 주목적은 외부 기상 조건의 영향을 받지 않고 고품질의 상품을 출하하는 것이므로 작물의 생육 및 생장에 관련된 기술 개발이 필요한 상황이다. 그러기 위해 스마트팜 내에서 식물의 지속적인 관찰 및 내부 환경 제어는 필수적이다. 특히 농작물에 적합한 환경을 조절하기 위해서는 시간에 따라 변동되는 재배식물의 정보를 실시간(real-time)으로 모니터링해야 한다(NICE, 2020). 이러한 시계열 정보에는 식물의 크기, 색상, 병해충의 유무, 생체중, 엽면적 등이 있다. 식물의 색상 및 병해충의 유무에 대한 데이터는 일반적인 영상 카메라(RGB camera)를 통해 쉽게 확인이 가능하지만, 식물의 크기 및 엽면적을 파악하기 위해서는 정밀한 측정이 필요하다. 식물의 크기 및 면적은 식물의 생장과 수확량뿐만 아니라 생산량, 광합성, 관개 및 시비에 대한 반응에 영향을 미치는 중요한 특성이다. 따라서 식물의 개별적인 잎의 생장을 추정하는 것은 작물의 생장과 작물과 환경 간의 상호 작용을 이해하고 실내 농장에서 효과적으로 관리하기 위해 필수적인 과정이다(Launay와 Guérif, 2003).

잎 표면적의 중요성은 많은 연구에서 언급되고 있다. 잎은 광합성, 증산 및 작물 생장에 중요한 역할을 하여 생산성과 직결된다(Mack 등, 2017). 대표적으로 디지털 이미지 분석, 레이저 광학 장치 등을 이용하여 엽면적을 측정하는 방법들이 있다(Deng 등, 2019; Boyacı와 Küçükönder, 2022; de Lucena 등, 2019; Zhang, 2020). 디지털 이미지를 이용한 연구의 대다수는 잎사귀의 정사형 이미지를 얻기 위해 파괴적인 방법을 이용한다. 이러한 파괴적인 측정 방법은 스마트팜 내에서 잎의 생장을 측정하기 위해 많은 시간과 비용이 들고 측정 대상인 식물의 생장에 영향을 미칠 수 있다. 따라서 비(非) 파괴적인 방식의 측정이 필요하다(Peksen, 2007).

식물의 너비와 길이를 이용하여 엽면적을 측정하는 방법은 특별한 장비 없이 모델 학습을 위한 데이터와 컴퓨터만 있으면 된다. 이 주제에 대해서는 이미 많은 연구자들이 다양한 식물 종을 이용하여 선형회귀를 통해 선형방정식을 만들었다. Souza와 Habermann (2014)은 독립변수로 너비와 길이, 너비와 길이 제곱을 독립변수로 사용하여 Styrax pohlii 및 Styrax ferrugineus종의 엽면적을 추정하였으며 Fakir 등(2013)은 pigeon pea의 너비와 길이, 생체중 및 건체중을 이용하여 선형회귀모델을 만들어 엽면적을 추정했다. 이외에도 이미지를 이용한 비파괴적 방법도 연구되고 있다. Hajjdiab와 Obaid (2010)은 2×2cm 흰색의 사각형 이미지(calibration square)를 이용하여 잎과 함께 사진을 찍어 윤곽을 추출, 픽셀을 이용해 면적을 예측한다. 그러나 이 경우에는 직접 잎에 판을 접촉하여 촬영해야 함으로 대규모 농장에선 활용이 어렵다. 따라서 따로 조작을 가하지 않고 본 형태 그대로를 촬영하는 것이 더 좋은 방안이다.

현장에서 직접 사진을 찍을 때 변화하는 빛으로 인한 노이즈 등 환경변수들이 있으므로 이미지의 강력한 특징추출을 위한 합성곱 신경망(convolution neural network, CNN)을 사용할 수 있다. 이는 여러 연구에서 보편적으로 이미지 분류작업에 사용되었지만, 생장 값 특징추출에 관한 연구는 상대적으로 적다. Gang 등(2022)은 수직에서 찍은 상추의 RGB-D 이미지를 이용하여 중량 및 높이, 엽면적 등을 예측하였으며 Zhang 등(2020)은 온실 상추 이미지를 이용해 CNN이 생장 관련 특성의 정확한 예측을 할 수 있음을 보여준다. 따라서 본 연구에서는 이미지와 CNN을 이용하여 상추의 엽면적을 예측하는 데 주로 사용되는 잎의 길이와 너비를 최대한 정확하게 예측하는 모델을 제시한다.

사용된 로메인 상추의 모든 데이터는 AIHub(aihub.or.kr)의 ‘지능형 수직농장 통합 데이터(엽채류)’의 데이터이며, 이 데이터는 상추의 이미지와 경계 박스, 길이와 너비 외에도 다양한 생육 정보들을 가지고 있다. AIHub는 정부에서 인공지능 제품·서비스 개발 및 성능 향상에 필수적인 인공지능 학습용 데이터, 알고리즘, 고성능 컴퓨팅 자원을 활용할 수 있도록 구축된 플랫폼으로써, 국내 기업 및 대학, 연구기관, 개인 등 누구나 서비스에 접근할 수 있으며 양질의 데이터를 쉽게 활용할 수 있는 오픈소스 시스템이다(NIA, 2019). 학습용 데이터 세트가 크지 않기 때문에 VGG16, Resnet152, NASNetMobile 등 사전 훈련된 CNN 모델들을 사용하였다(Nasiri 등, 2021). 모델의 성능을 평가하기 위해 평균 절대 오차(mean absolute error, MAE), 평균 제곱근 오차(root mean squared error, RMSE), 평균 절대 비율 오차(mean absolute percent error, MAPE), 결정계수(R-squared, R2)를 활용하여 최적의 모델을 찾는다.

재료 및 방법

1. 하드웨어 및 소프트웨어

본 연구에서 사용한 컴퓨팅 환경은 AMD Ryzen 7 5800X 프로세서와 NVIDIA GeForce RTX 3060 12G 그래픽 카드를 탑재한 시스템이다. 소프트웨어 환경으로는 python 3.7.16을 기반으로, keras 2.10.0 및 tensorflow 2.11.0과 tensorflow-gpu 2.10.1을 사용하였다. 데이터 처리와 분석을 위하여 numpy 1.21.6, pandas 1.3.5, scikit-learn 1.0.2, matplotlib 3.5.2를 활용하였다.

2. 데이터 세트

본 연구에 사용된 데이터는 AIHub에서 제공하는 “지능형 수직농장 통합 데이터(엽채류)”의 상추 데이터를 활용하였으며, 2021년 재배된 로메인 상추(Lactuca sativa L.)이다. 전체 데이터세트는 41,627개의 원천 이미지와 이에 대응하는 생육 데이터는 json 파일로 구성되어 있다. 이미지 데이터는 데이터 구축 기관의 현장 점검 후 스마트폰 카메라를 고정하여 촬영하고, 수집되었으며, 해상도는 10만 화소 이상을 갖는 RGB 3채널 JPG 형식으로 되어 있다. 각 이미지와 관련된 정보는 json 파일 형태로 제공되며, 이미지의 상세 정보, 재배 환경 정보, 생육 지표, 그리고 어노테이션 정보 등을 포함하고 있다.

전체 이미지 중에서 28,847개는 적색광에서 재배된 상추 이미지(Fig. 1)로 구성되어 있으며, 그 중, 엽폭과 엽장 데이터를 포함하는 이미지는 총 2,321개로, 이를 다시 64%(1,485개)의 훈련 데이터, 16%(372개)의 검증 데이터, 그리고 20%(464개)의 테스트 데이터로 구분하여 활용하였다. 상추잎의 엽폭과 엽장 데이터는 각 잎에 대한 수치(cm)로 제공되며, 이를 분석에 활용하기 위해 바운딩 박스(bounding box, bbox)를 사용하여 각 잎을 정확하게 추출하였다(Fig. 2). 복수의 json 파일로 되어 있는 데이터들은 분석의 편의를 위해 하나의 csv 파일로 통합 저장하였다. 본 연구에서 모델의 학습에 사용된 주요 정보는 엽폭, 엽장, 그리고 바운딩박스 정보였다.

3. 영상 전처리

본 연구에서는 훈련 데이터의 다양성과 양을 동시에 증대시키기 위해 Keras의 ImageDataGenerator 함수를 활용하였다. 이 함수를 통해 원본 이미지 데이터에 다양한 변형을 적용하여 새로운 변형 데이터를 생성하였다. 원본 데이터와 변형 데이터를 함께 사용함으로써, 학습 데이터의 양과 다양성이 증가할 수 있으며 이러한 데이터 증강 기법은 모델의 일반화 능력 향상에 큰 도움을 주고 특히 부족한 양의 학습 데이터를 가지고 있는 상황에서 매우 유용하다. 전처리 과정에서 이미지의 픽셀값은 0과 1 사이로 정규화되었다. 추가로, 데이터 증강으로 이미지는 최대 30도의 각도로 회전되었고, 동일한 범위로 전단 변환이 적용되었다. 더불어, 이미지는 최대 30픽셀 내에서 수평 및 수직으로 이동시켜졌으며, 이미지의 수평 및 수직 반전도 무작위로 적용되었다. 뿐만 아니라, 각 컬러 채널의 값을 임의로 조정하여 이미지의 컬러 분포를 변형시켰다. 이러한 방법들을 통해, 데이터 증강은 모델이 실제 환경에서의 다양한 변동성에 대응할 수 있도록 도와줄 수 있다.

4. K겹 교차검증

K겹 교차검증(K-fold cross validation)은 모델의 일반화 성능을 평가하기 위해 전체 데이터를 K개의 집합으로 분할하는 방법이다. 각 분할에서, 하나의 집합을 검증 데이터로 사용하고 나머지를 훈련 데이터로 활용한다. 이 과정은 K회 반복되며, 모든 검증 결과를 평균 내어 성능을 평가한다. 본 연구에서는 5겹 교차검증을 사용하였으며, Scikit-learn 라이브러리를 활용하여 데이터를 5개의 겹으로 나누었다.

5. 모델 아키텍처 선택

본 연구에서 사용한 딥러닝 모델 아키텍처는 ImageNet 데이터 세트에서 사전 훈련된 VGG16, Resnet152, NASNetMobile로 구성되어 있다. 이 아키텍처들을 활용하여 전이 학습의 접근 방식을 채택하였다.

5.1 VGG16

VGG는 Karen Simonyan과 Andrew Zisserman에 의해 2014년에 개발된 딥러닝 아키텍처이다(Simonyan와 Zisserman, 2014). 이 아키텍처는 이미지 분류 문제에서 네트워크의 깊이가 분류 정확도에 어떤 영향을 미치는지 연구하였다. VGG16은 이름에서 알 수 있듯이 16개의 계층을 포함한 버전이며, 3x3의 작은 컨볼루션 필터를 핵심 구성 요소로 사용한다. 2014년 ImageNet 챌린지에서 이 아키텍처는 localization 부문에서 1위, 분류 부문에서는 2위를 차지하는 뛰어난 성과를 보였다.

5.2 Resnet152

Resnet(잔여 네트워크) 아키텍처는 2015년에 Kaiming He, Xiangyu Zhang, Shaoqing Ren, 그리고 Jian Sun에 의해 설계되었다(He 등, 2016). 이 구조는 매우 깊은 신경망 분석에서 발생할 수 있는 경사 소실 문제를 해결하기 위한 방안으로 개발되었다. Resnet 아키텍처는 “short cut” 또는 “skip connection”을 도입하여 계층 간의 정보 흐름을 개선하였다. Resnet152는 총 152개의 계층으로 이루어져 있으며, 매우 심층적인 구조를 가진 강력한 분류 모델 중 하나이다.

5.3 NASNetMobile

신경 구조 검색(Neural Architecture Search, NAS)은 Barret Zoph와 Quoc Le에 의해 2017년에 도입된 모델 설계 자동화 방법이다. NAS는 순환 신경망(RNN)을 활용하여 모델 구조를 설계하고, 이를 강화학습 기법으로 최적화한다. NASNetMobile모델은 NAS 방법론을 사용하여 2018년에 도입된 아키텍처로, 효율적인 연산과 낮은 파라미터 수를 가진 모델로서, 특히 모바일 환경에 최적화된 구조를 지니고 있다. 이 아키텍처는 여러 블록으로 구성되며, 각 블록은 합성곱, 풀링 연결 등의 다양한 연산을 포함하고 있다(Zoph와 Le, 2016; Zoph 등, 2018).

6. 성능지표

모델은 손실함수로 MAE및 MSE, 혼합함수[α×MAE+(1−α)×MSE]를, 최적화를 위해 Adam 및 RMSprop을 사용하고 성능평가를 위해 RMSE, MAPE, R2 등을 사용하였다. MAE는 예측값과 실제 값 간의 절대 차이의 평균으로 계산된다. MAE는 다음과 같은 식 (1)로 표현된다.

RMSE는 예측 오차의 제곱 합의 평균에 루트를 적용한 값이다. RMSE는 다음과 같은 식 (2)로 계산된다.

MAPE는 실제값과 예측값 간의 백분율 오차의 평균으로, 다음과 같은 식 (3)으로 표현된다.

R2는 독립 변수에서 예측할 수 있는 종속 변수의 분산 비율을 측정한다. 식 (4)로 계산되며 식 (5)는 전체 제곱합(total sum of squares, SST)로 실제값에서 실제값의 평균을 뺀 결과의 총합, 식 (6)은 추정 제곱 오차합(explained sum of squares, SSE)로 예측값에서 예측값의 평균을 뺀 결과의 총합, 식 (7)은 잔차제곱합(residual sum of squares, SSR)로 실제값에서 예측값을 뺀 값, 잔차의 총합이다.

7. Keras.callbacks

부족한 데이터양과 그 다양성으로 인해 과적합의 위험이 증가하기에 이러한 과적합 문제를 완화하기 위해, 학습률의 조정을 중심으로 한 전략을 적용하였다. 이를 위해 Keras framework의 callbacks 기능 중, 학습률을 동적으로 조절할 수 있는 LearningRateScheduler와 ReduceLROnPlateau를 활용하였다. LearningRateScheduler는 각 Epoch이 진행될 때마다 학습률을 사용자가 지정한 수치에 따라 주기적으로 변경시켜 준다. 이러한 학습률 변화를 통해 극소점(local minima) 문제를 효과적으로 극복할 수 있다. ReduceLROnPlateau는 모델의 학습 진행 중 특정 지표(예: validation loss)가 지정한 연속 에폭(Epoch) 동안 개선되지 않을 경우, 학습률을 감소시키는 방법을 사용한다. 이를 통해 학습이 고원에 도달했을 때, 학습률을 감소시켜 학습의 진행을 더욱 원활하게 해준다.

8. 학습 모델

모델 훈련은 총 300회 동안 진행되었으며, 각 배치(batch)의 크기는 학습 데이터는 48개, 검증 데이터는 12개로 설정하였다.

결과 및 고찰

1. 콜백 함수

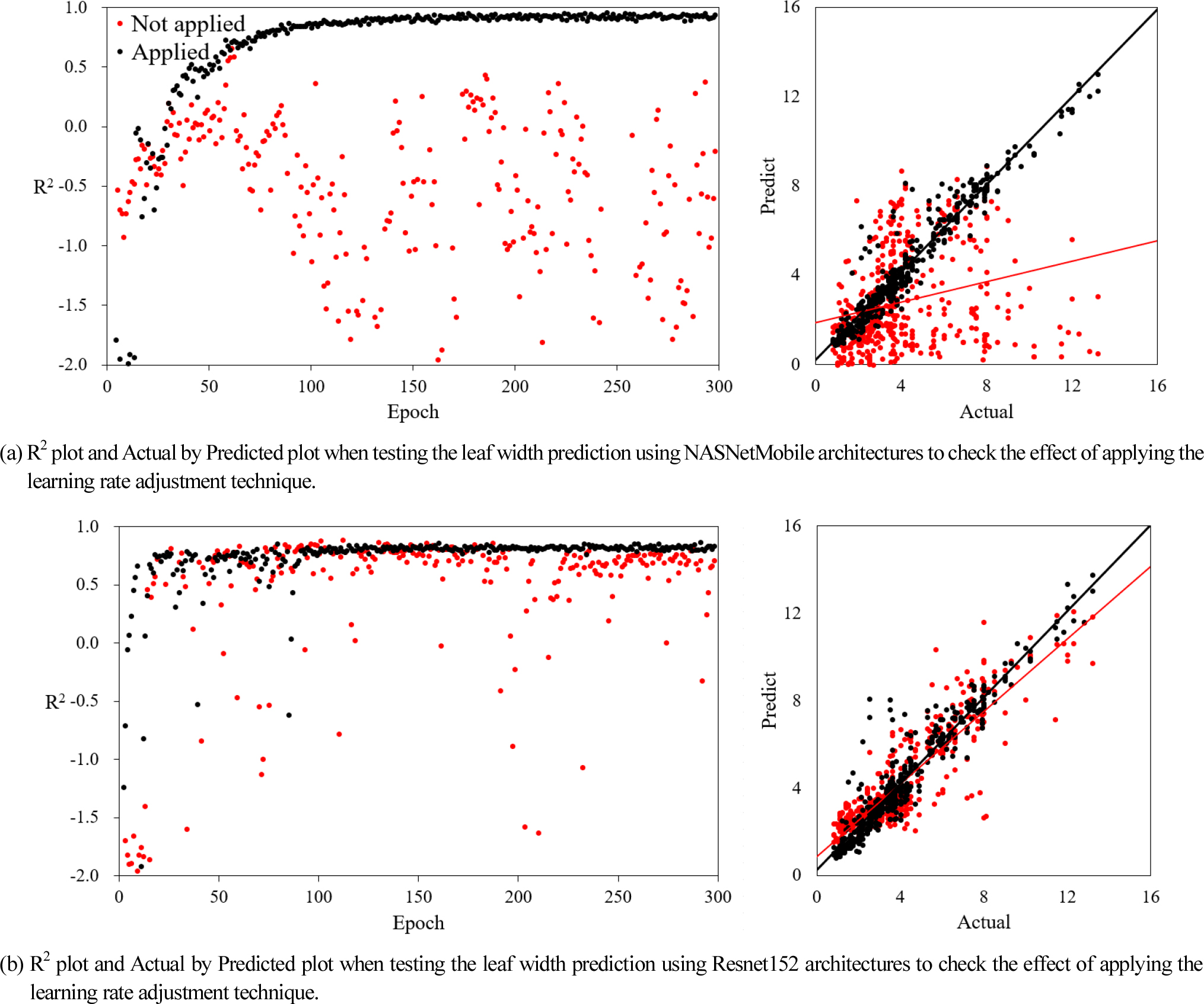

Fig. 3의 (a)는 콜백(callback)함수의 사용 여부에 따른 성능 차이를 보기 위해 NASNetMobile 모델에 대한 실험 결과를 시각화한 것이다. 성능 차이를 보기 위해 R2 값을 활용했다. 콜백함수를 사용하지 않은 모델에서 R2 값은 엽폭이 0.065, 엽장이 0.079로 낮게 측정되었다. 반면, 콜백함수를 도입한 모델에서는 엽폭이 0.915, 엽장이 0.933으로 상당히 높아진 것을 볼 수 있다. 이는 콜백함수의 적용이 모델의 일반화 능력을 크게 향상한 것으로 해석된다.

Fig. 3의 (b)는 Resnet152 모델에 대한 실험 결과를 나타낸다. NASNetMobile 모델과 유사한 패턴을 보이는 것을 확인할 수 있는데, 콜백함수의 미적용 시 R2의 값은 엽폭이 0.78, 엽장이 0.795로 측정되었으며, 적용 시에는 각각 0.889와 0.915로 증가하였다. 이 역시 콜백함수의 도입이 모델 성능의 긍정적인 효과를 가져온 것을 확인할 수 있다.

결론적으로, 두 모델 모두에서 콜백함수의 적용이 학습의 효율성과 성능을 개선시키는 중요한 역할을 하는 것으로 나타났으며, 작은 데이터셋에 대한 반복 학습에서 과적합을 방지하거나 학습률을 조절하여 최적의 결과를 도출하는 데 효과적이라는 것을 이 실험을 통해 확인할 수 있었다.

2. 아키텍처 비교

본 연구에서는 세 가지 주요 딥러닝 아키텍처, 즉 VGG16, Resnet152, 그리고 NASNetMobile에 대한 성능을 비교 분석하였다. 완전연결층의 활성화 함수로는 ReLU, 손실함수로는 MAE를 사용하여 비교하였다. 학습은 총 300회 실시하였으며, 모델의 검증 성능은 R2, RMSE를 기반으로 평가하였다(Fig. 4).

아키텍처의 비교를 통하여 NASNetMobile의 R2 및 RMSE가 가장 좋은 성능을 보인다는 것을 알 수 있다. R2가 엽폭에서 0.9064, 엽장에서 0.9294이라는 수치를 기록하였으며 가장 높은 수치인 것을 볼 수 있다. RMSE 또한 엽장에서 0.7212, 엽폭에서 1.0647이라는 수치를 기록하여 셋 중 가장 낮은 수치인 것을 볼 수 있다.

3. 손실함수 및 활성화함수 비교

앞선 결과를 통해 나온 NASNetMobile 아키텍처를 사용하며, 완전 연결층의 손실 함수 및 활성화함수를 변화시켜 비교하였다. 손실함수로는 MAE, MSE와 두 함수에서 0.5의 가중치를 사용한 합성함수를, 활성화 함수로는 ReLU와 ELU를 사용하여 비교하였다. 학습은 총 300 Epoch 실시하였으며, 모델의 검증 성능은 R2, RMSE를 기반으로 평가하였다(Fig. 5).

손실함수와 활성화함수의 비교를 통하여 MSE와 ELU의 조합에서의 R2 및 RMSE가 가장 좋은 성능을 보인다는 것을 알 수 있다. R2가 엽폭에서 0.9382, 엽장에서 0.9568이라는 수치를 기록하였으며 가장 높은 수치인 것을 볼 수 있다. RMSE 또한 엽장에서 0.5934, 엽폭에서 0.8275라는 수치를 기록하여 비교군 중 가장 낮은 수치인 것을 볼 수 있다.

4. 옵티마이저 비교

앞선 결과를 통해 나온 조합을 이용하여 optimizer를 변형시켜 각각 동일 데이터세트에서 비교 시험하였다. 총 다섯 번 반복시험 하였으며 각각의 결과는 1-5로 표기하였다(Fig. 6). W는 엽폭 예측이며 L은 엽장 예측이다.

R2를 확인해 보면 RMSprop이 adam에 비해 높은 모습이다. W1에서 0.9436의 값을 L4에서 0.9537의 값을 보인다. RMSE 같은 경우 엽장 예측에서 RMSprop이 더 낮은 모습을 보였으며 엽폭 예측에서는 비슷하거나 더 낮은 모습을 보인다. W1에서 0.5659의 값을 L5에서 0.8713의 값을 보인다.

최종적으로 아키텍처는 NASNetMobile, 손실함수는 MSE, 활성화 함수는 ELU, optimizer는 RMSprop의 조합이 좋은 결과를 보였다.

결 론

본 연구는 ‘Ai Hub’에서 제공하는 로메인 상추 이미지와 그에 대한 생장 데이터를 활용하여 상추의 폭과 길이를 정밀하게 예측하는 딥러닝 모델을 개발하였다. 이 과정에서, 다양한 파이썬 라이브러리들을 사용하여 다양한 아키텍처와 최적화 방법을 사용하였다. 데이터의 부족과 과적합 문제를 극복하기 위해, 콜백 함수를 적용하였으며, K겹 교차검증을 통해 모델의 일반화 능력을 향상했다. ImageDataGenerator 함수를 활용하여 데이터 증강 기법도 도입하여 훈련 데이터의 다양성을 높였다. 폭과 길이 예측에서 모두 NASNetMobile 모델이 높은 성능을 보였으며, 폭의 경우 R2 값이 0.9436, RMSE는 0.5659를 기록하였다. 길이 예측에서는 R2 값이 0.9537, RMSE는 0.8713의 값을 기록하였다.

이러한 결과는 현대 농업 환경, 특히 스마트팜이나 수직 농장에서 고정 또는 이동형 카메라를 활용해 지정 식물의 크기를 예측하여 생장 상태를 실시간으로 관찰한 후 해당 식물의 추가적인 양액 급여 및 관수 감소 등의 생육환경을 조성하는 데 도움이 될 것으로 기대된다. 그러나 실제 학습데이터가 제공된 농장에 적용하기 위해서 더 많은 데이터와 다른 위치 등을 고려한 추가적인 연구가 필요할 것으로 판단된다. 앞으로의 연구 방향은 추가적인 상추 영상과 다양한 최신 아키텍처를 활용, 학습하여 모델의 성능을 더욱 향상하는 것이며, 실제 현장에 적용하기 위해서 현장에서 직접 얻어진 상추 영상을 대상으로 개선된 객체 검출 알고리즘을 적용하여 상추잎 영역만을 보더 정확하게 추출하는 모델을 개발하고자 한다.